Sí, Promptus ejecuta ComfyUI localmente, con un servidor de GPU y flujos de trabajo en una sola instalación.

ComfyUI se ha convertido en la opción líder para los creadores que crean arte, vídeo y 3D con IA. Sin embargo, una pregunta frecuente es: ¿Funciona localmente? Sí, y puede funcionar muy bien, especialmente cuando se usa a través de Prompus con ComfyUI.

En este artículo, veremos exactamente cómo puedes ejecutar ComfyUI de forma local y qué hardware de GPU necesitarás realmente para varios flujos de trabajo populares, como SDXL, Flux, AnimateDiff/WAN2.x, los escaladores y la pintura y superpintura.

Qué significa ejecutar «localmente»

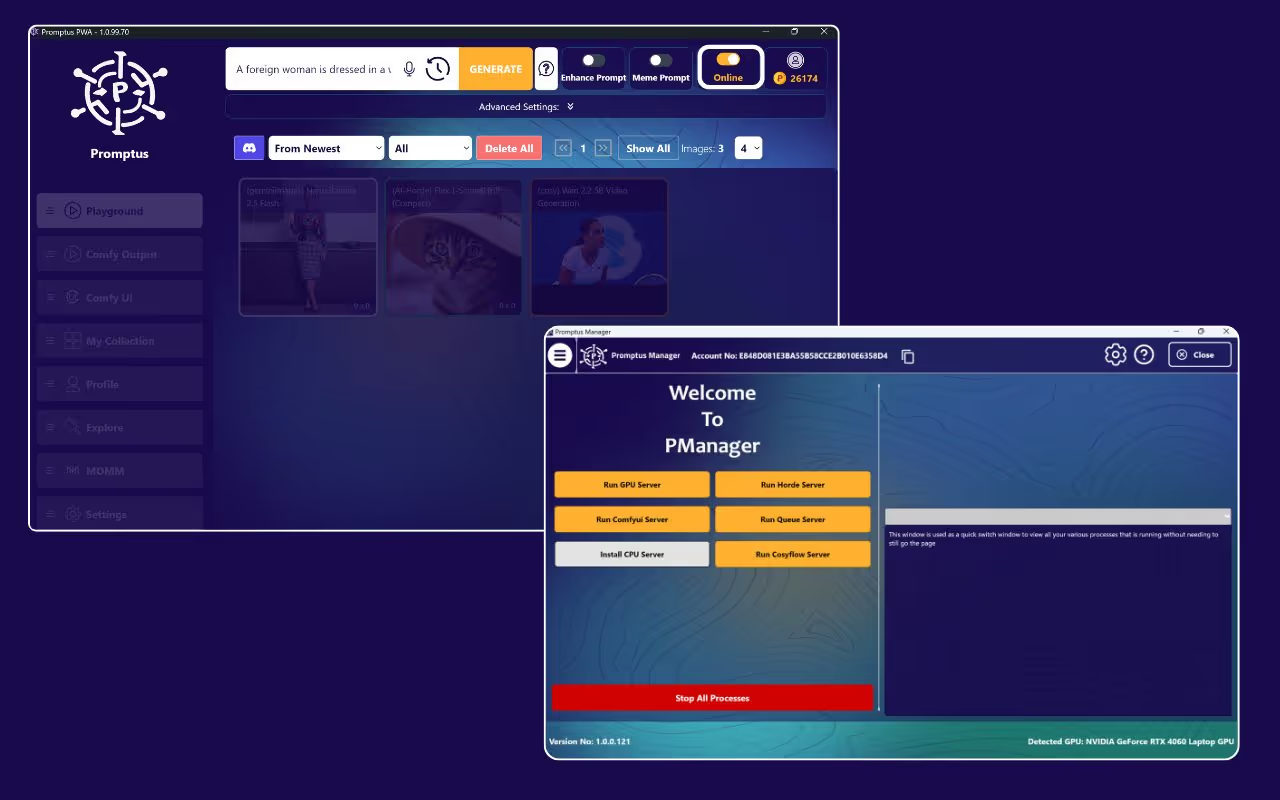

La ejecución local significa que todo el procesamiento (generación, inferencia de modelos, renderizado) tiene lugar en tu propio ordenador, sin depender de servidores en la nube. Con Promptus + ComfyUI:

- Lo descargas e instalas todo (el servidor de GPU, los modelos, los flujos de trabajo).

- Activa el «Modo sin conexión» para que la generación no envíe datos ni utilice servidores externos.

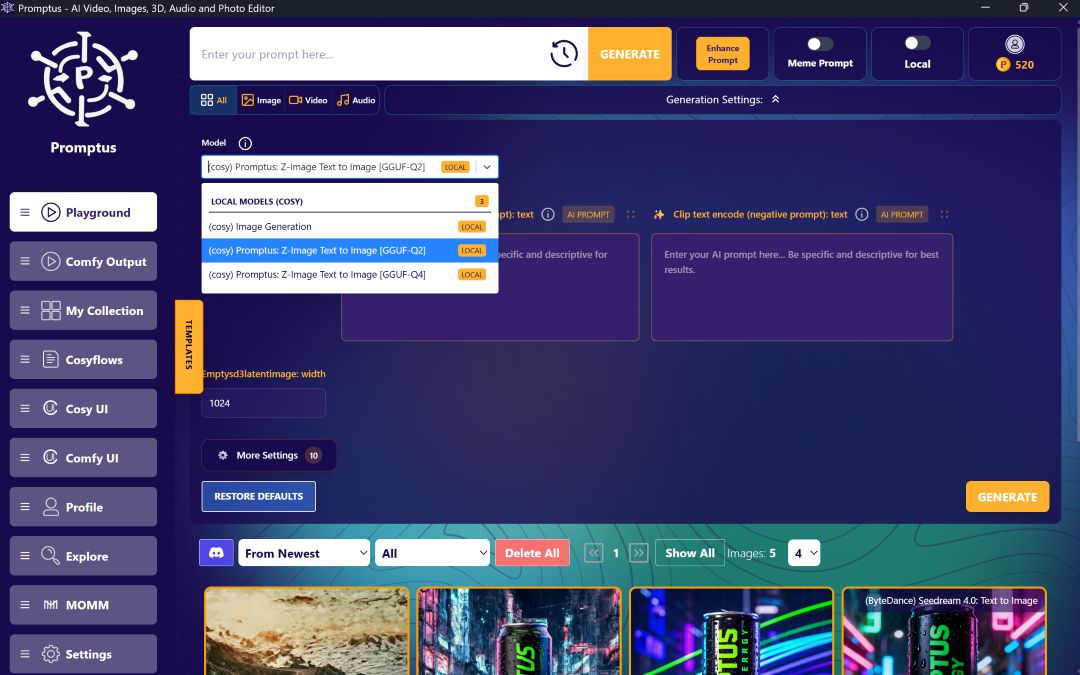

- Tú controlas qué modelos utilizas (SDXL, Hunyuan, Flux, etc.) y qué flujos de trabajo (vídeo, imagen, 3D).

Los mejores flujos de trabajo de ComfyUI 🔧

Estos son algunos de los flujos de trabajo de ComfyUI más populares, lo que hacen y las GPU que la gente usa (o recomienda) para ellos.

👉 Si quieres bucear más profundo, aquí tienes una lista de mejores flujos de trabajo de ComfyUI puedes intentarlo.

Configuración local de ComfyUI 🖥️

Así es como los creadores suelen ejecutar ComfyUI localmente con Promptus, utilizando los principales flujos de trabajo anteriores:

- Descargar Promptus e instala la aplicación para escritorio.

- En la aplicación, ve a Perfil → Abrir ComfyUI Manager.

- Haga clic Ejecutar GPU Server → Instalar. Promptus gestiona las dependencias, incluida la configuración de Python, la interfaz de la GPU, etc.

- Cuando esté listo, cambia la aplicación a Modo offline para que todo funcione en su hardware (imágenes, vídeo, 3D).

- Descargue los modelos necesarios (SDXL, Hunyuan, Flux, etc.) para almacenarlos localmente.

- Seleccione un flujo de trabajo (por ejemplo, generación de imágenes SDXL o vídeo WAN2.x) y genere. Promptus le permite elegir flujos de trabajo sin necesidad de conectar manualmente los nodos.

Ejemplos y ventajas de GPU del mundo real 🔍

- Un usuario que intenta Flujo de trabajo FP8 de WAN 2.2 Primer-Last Frame informó que para funcionar sin problemas, especialmente para el vídeo, un RTX 4090 con 24 GB de VRAM se recomienda encarecidamente; las GPU de gama baja son posibles con modelos cuantificados o de menor precisión, pero la calidad o la velocidad disminuyen.

- Para SDXL con una resolución moderada (1024 × 1024), la VRAM de 12 a 16 GB funciona con bastante comodidad (por ejemplo, RTX 3060 o 4070). Pero una vez que llegas a 2048 × 2048, o quieres un refinamiento limpio (especialmente caras, etc.), empiezas a querer tener más de 20 a 24 GB.

- Opciones de VRAM bajas: la variante GGUF de los modelos de imagen a vídeo Wan2.2 puede ejecutarse en sistemas con menos de 12 GB de VRAM — pero tendrá que aceptar las limitaciones (resolución más baja, procesamiento posiblemente más lento, tamaños de lote más bajos).

Entonces, ¿ComfyUI funciona localmente, de verdad? ✅

Sí, absolutamente. Y con herramientas como Promptus, más personas que nunca lo utilizan localmente como su configuración principal. Si tienes una GPU con entre 12 y 16 GB de VRAM, estupendo.

Si tiene menos, puede seguir ejecutando muchos flujos de trabajo (especialmente el aumento de escala, la inserción de pintura y la generación de imágenes más sencilla), pero espere velocidades más lentas o salidas de menor resolución.

Para vídeos pesados y 3D, más de 24 GB comienzan a ser muy útiles o incluso necesarios.

Consejos para obtener el mejor rendimiento local

- Utilice FP16/ modelos cuantificados cuando sea posible (ayuda a reducir el uso de VRAM).

- Empieza con resoluciones moderadas (1024 × 1024) en lugar de pasar directamente a 4K.

- Disponga de almacenamiento SSD rápido para los modelos. Disco lento = tiempos de carga prolongados.

- Mantener la RAM del sistema: 16-32 GB es útil para almacenar datos y gestionar modelos grandes.

- Mantenga los controladores y ComfyUI/Promptus actualizados; a veces se producen optimizaciones que reducen los requisitos de VRAM.

Resumen 🔎

- Cómoda UI hace se ejecuta localmente, especialmente cuando se usa a través de Promptus.

- Puede ejecutar flujos de trabajo de SDXL, Hunyuan, Flux, AnimateDiff/WAN2.x, escalar e insertar localmente; la clave es tener suficiente memoria de GPU y utilizar flujos de trabajo optimizados cuando sea necesario.

- Promptus simplifica la configuración: descarga, instala el servidor GPU, cambia al modo fuera de línea, elige el flujo de trabajo y genera.

%20(2).avif)

%20transparent.avif)